2025年度1Q(2-4月期)決算の電話会議で、フアンCEOなどの経営陣は、CUDAでトレーニングや推論性能が高まっていること、H200 GPUの供給不足が当面続きそうなこと、新しい事業機会(国家AI、PC向けCPU/GPU製品への参入可能性など)が語られました

供給は引き続き課題で、「H200」や「Blackwell」は2025年にかけて不足が続く可能性を指摘しました

需要に関しては中国市場の厳しい環境を除いて、特段ネガティブなコメントは聞かれませんでした

データセンター需要の持続性は、顧客であるクラウドプレーヤーなどが十分な収益を上げられるかにかかっていますが、今後4年間はNVDAのGPUを活用することで十分な売上高を挙げられるとの認識も示しました

時間外の株価は、終値比6%高の1,007ドルで終えました

2025年度1Q決算 電話会議の主な経営陣コメント

- 1Qのデータセンター向け売上高はエンタープライズ向けが牽引した

- CUDA上でのAIトレーニングと推論はクラウドサービスの売上高成長を大いに加速させている。H100によるLLMの推論を最大3倍高速化できた

- ラウド企業はエヌビディアAIインフラに1ドル投じるごとに、GPUホスティングで5ドルを稼ぐ機会が今後4年間ある

- H200の推論パフォーマンスはH100の約2倍で、たとえばMETAのLlama3(7,000億パラメータ)では単一のH200サーバーで1秒当たり24,000トークンを実現できる。かつ、同時に2,400以上のユーザーをサポートできる

- これは、H200サーバーに現在のトークン当たり価格で1ドル投じるごとに、Llama3を提供するAPIプロバイダーは7ドルを今後4年間得ることを意味する

- 1QにテスラのトレーニングAIクラスターを35,000個のH100 GPUに拡張することをサポートした

- METAは24,000個のH100 GPUクラスターで学習させたLlama3を発表した

- H100の供給は改善可能だが、H200は引き続き逼迫している

- H200は1Qにサンプル出荷を開始した。正式な出荷は2Qを予定している。先日のOpen AIのGPT-4oのデモでも利用された

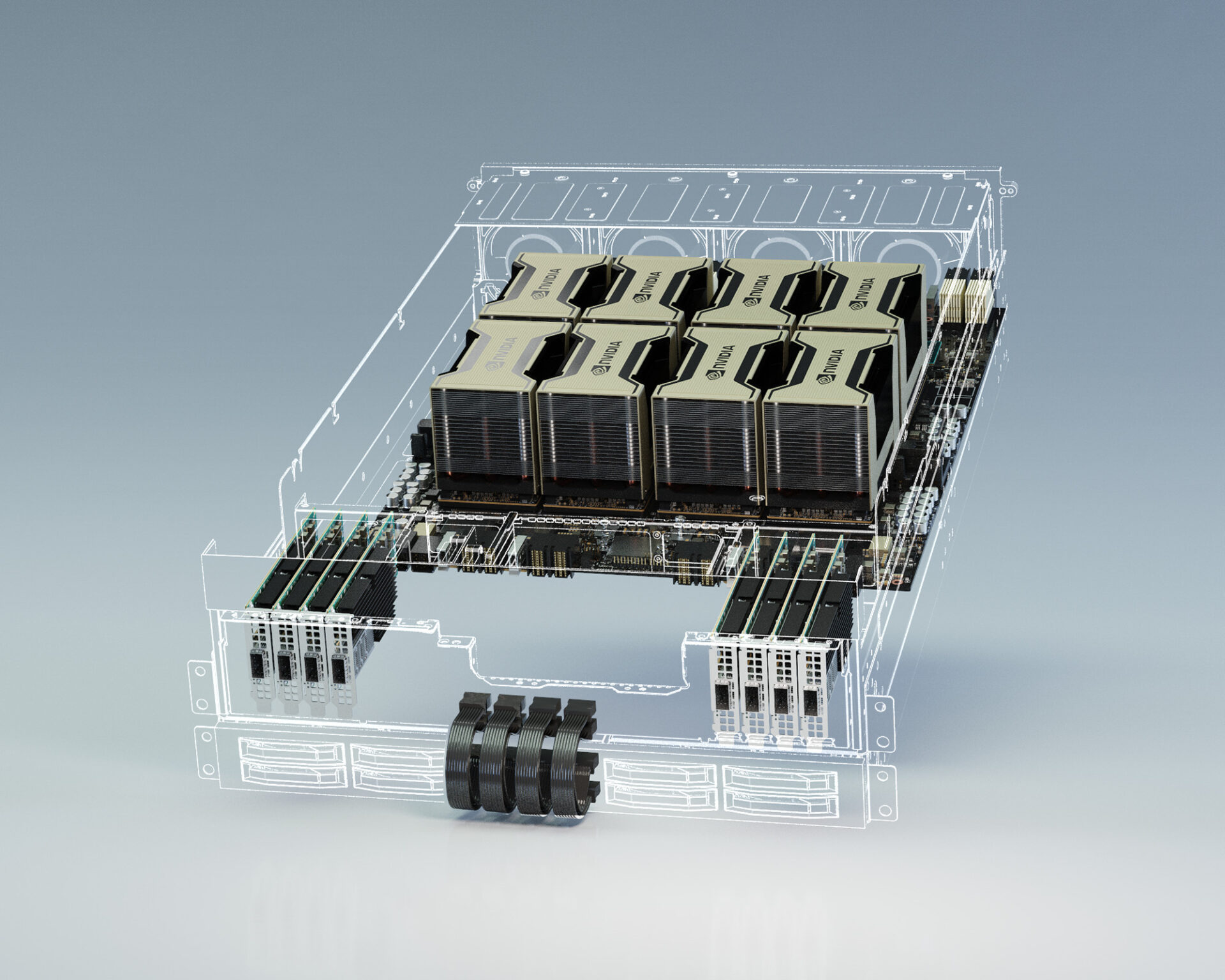

- H200とBlackwellの需要は供給を大きく上回っており、2025年にかけて現在の状況が続く見通し。Blackwellはフル生産体制にあり、2024年後半に世界全体で利用可能にある見通し

- Blackwellは立ち上げ時に、100超のOEMと100超のODMで利用可能になる。Hpper立ち上げ時の2倍以上の数だ

- Blakwellの出荷は2Qに始まり、3Q(8-10月期)に加速、4Q(11-1月期)に多くの顧客のデータセンターに搭載される見通し

- Blackwellの顧客には、アマゾン、グーグル、メタ、マイクロソフト、Open AI、xAI、オラクルなどを含む

- CPUは、データセンターのようにクライアント(PC)向けにも機会があれば検討していく

- 国家AI向けの売上高は2024年に1桁台後半億ドルが見込まれる

- 中国向けデータセンター売上高は、新たな輸出規制(2023年10月)の発動前の水準を大きく下回っている。中国市場は今後も非常に競争が激しくなると予想している